Cuando pensamos en un humanoide convincente, lo imaginamos mirándonos a los ojos, parpadeando y acompañando las palabras con gestos que dan contexto. La robótica avanza a buen ritmo y hay máquinas que resuelven acrobacias con solvencia, pero todavía transmiten más mecánica que humanidad. Lo que falta para que la interacción fluya es el gesto que completa el mensaje. En los últimos meses, anuncios y pruebas en China han empezado a explorar exactamente esa capa.

Del músculo a la cara. Durante mucho tiempo, el listón estuvo en conseguir que un robot se desplazara con autonomía y superara pruebas de resistencia. Ese capítulo empieza a estar resuelto con modelos cada vez más sólidos en el plano mecánico. Lo que ahora se plantea es otro desafío: reproducir la comunicación no verbal que las personas damos por sentada. Desde un gesto de aprobación hasta una reacción de sorpresa, son señales que abren la puerta a un diálogo real entre humanos y máquinas.

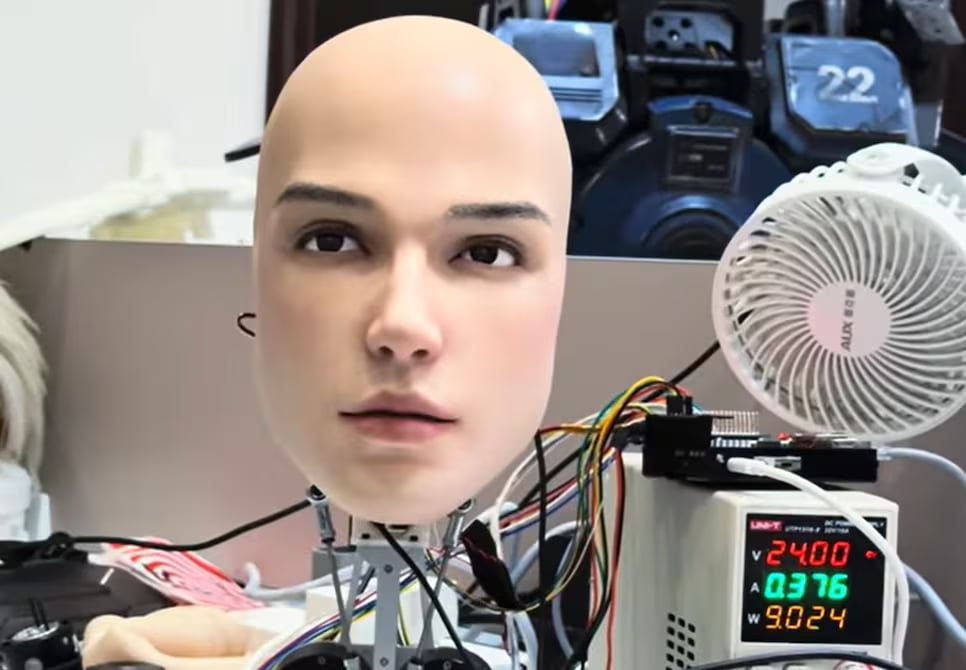

Una cabeza que gesticula. La empresa china AheadForm ha mostrado un prototipo que materializa esta transición. En un vídeo difundido en YouTube se ve una cabeza robótica que parpadea, asiente y sigue el entorno con la mirada de forma sorprendentemente convincente. La compañía, fundada en 2024, explica en su web que su objetivo es lograr interacciones más naturales entre personas y máquinas. Para ello busca integrar modelos de lenguaje avanzados con expresiones faciales realistas que permitan responder en tiempo real.

Bajo la ‘piel: Para lograr que el prototipo parezca vivo se ha recurrido a motores brushless, pequeños dispositivos silenciosos capaces de coordinar movimientos precisos. El modelo, bautizado como Origin M1, integra hasta 25 de estos actuadores que controlan las distintas expresiones. En sus pupilas se esconden cámaras que permiten registrar lo que ocurre alrededor, mientras que micrófonos y altavoces facilitan la interacción en tiempo real. La combinación de estos elementos explica los movimientos sutiles y la capacidad de respuesta.

Robot 2 Integración de una cabeza robótica de AheadForm en un cuerpo experimental

La compañía asegura que la utilidad de estos desarrollos irá más allá de la simple demostración técnica. Proyecta escenarios como la atención al cliente, la enseñanza o la asistencia sanitaria, donde la confianza se construye también con gestos y expresiones. El planteamiento es que un robot que sonríe o asiente inspira más cercanía que uno con rostro neutro. Por ahora, se trata de intenciones declaradas: los modelos no están disponibles comercialmente.

Respaldo académico. Detrás del vídeo hay también investigación revisada por pares. En Science Robotics, en 2024, Yuhang Hu y varios colaboradores presentaron un robot capaz de predecir y reproducir expresiones humanas a medida que se producían. El estudio aportaba evidencias de que el reconocimiento facial en tiempo real y la respuesta mecánica sincronizada son posibles. No confirma que el prototipo actual sea el mismo sistema del estudio, pero es coherente con la orientación que la empresa describe.